小僧鲲鲲

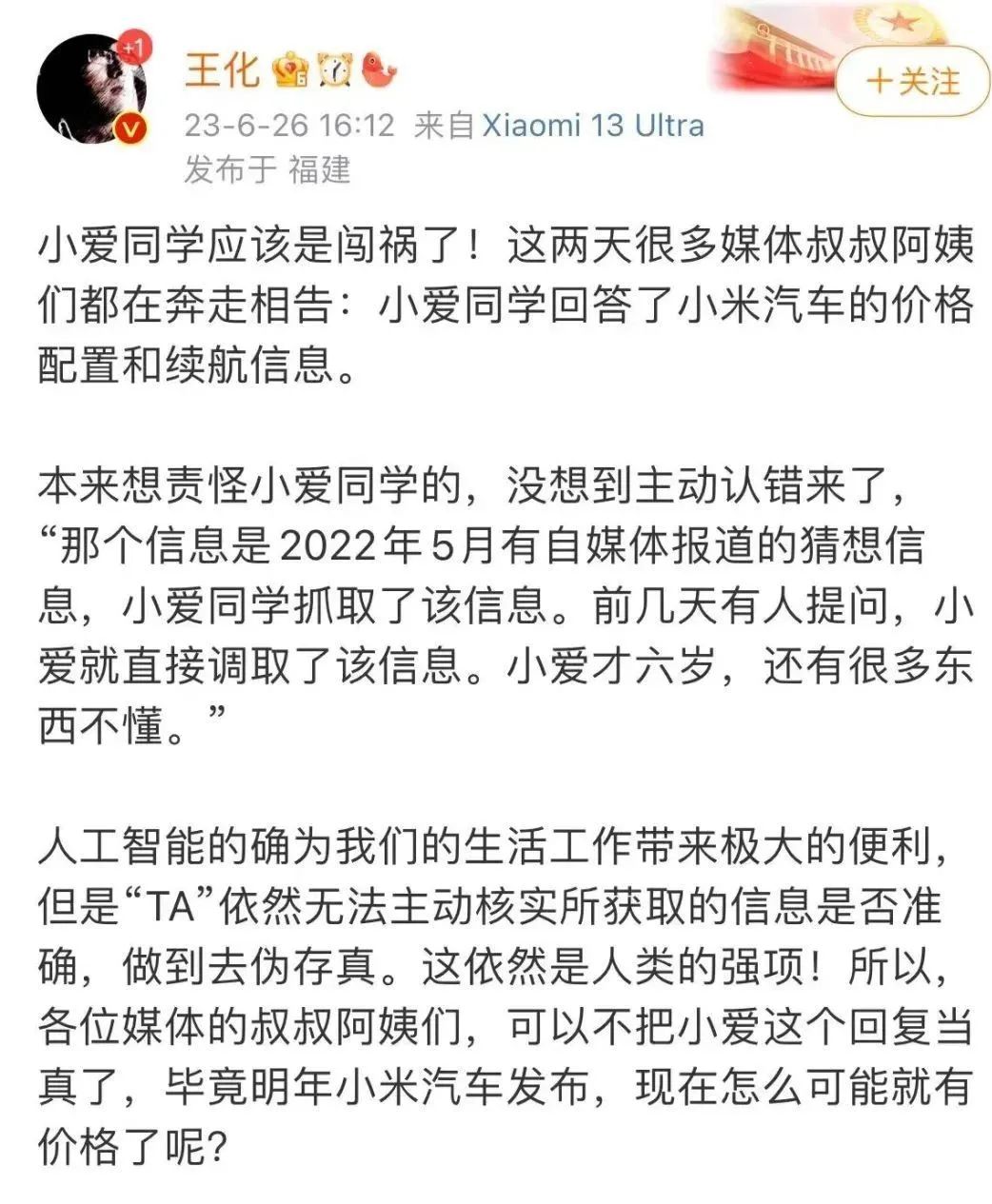

小僧鲲鲲在这个爆料常常被翻转的年代,辟谣已经将怪不怪,但是小米价格事件的翻转还是引发众多关注。近日,一张关于小米汽车车型价格的截图在网上流传,流出图显示,小米车型售价14.99万元起,最高续航达到800公里。不过没多久,小米公关负责人就在微博发文辟谣。

原来这是小爱同学通过检索搜索引擎信息生成的答案,实际上,此信息是2022年5月自媒体报道的猜想信息,有人提问小爱时,小爱同学抓取了这个猜想的信息而已。

小爱同学作为小米旗下的人工智能助手,其给的答案引发关注也不意外。确实,小爱同学辨别不了信息的真假,是无意为之。不过,这个事件让小僧想到了人工智能有意为之的胡编乱造现象,这就是被业界称之为的AI幻觉。

AI也会幻觉?人工智能时代引发生产力解放的狂欢,但在这背后,过度依赖人工智能的危机似乎已经显现!

什么是AI幻觉?

你有没有遇到过AI工具一本正经胡说八道的情况?

在人工智能领域,AI“幻觉”(hallucinations)通常被定义为“生成的内容与提供的源内容无意义或不可信”。也就是当模型出现“幻觉”时,其输出的内容、数据可能存在一定的欺骗性,而其所使用的训练数据并不能证明输出结果的合理性。

简单来说就是,AI有时候会生成一些子虚乌有的人或者事,并且保持一贯的自信,这些虚假的信息具有很强的误导性和欺骗性。

就连 OpenAI 的首席执行官也在 Twitter 上公开表示,“ChatGPT 确实知道很多东西,但危险的是,它在相当大的一部分时间里是自信而错误的。”

不过,幻觉这个词总给人一种AI具有生命力和思考能力的暗示,正因为如此,随着这一现象被越来越多的人关注,这个标签的争议也越来越大。小僧以为,AI“幻觉”事实上是一种信息的虚构,这种信息的虚构是基于AI模型造成的,而不是AI的主观思考能力或创造能力。

不管称呼如何,人工智能这种自我欺骗胡编乱造的现象已经不是个例,在AIGC浪潮之下,AI工具张口就来似乎成为了新时代的新常态。

AI张口就来的病

AI这种出现错误或者偏差,导致生成不准确、错误甚至荒诞结果的现象,可能发生在多个层面上,如文本的胡编乱造、事实的错误捏造、无用代码的生成,甚至给你一个编造的参考文献等等。

《华盛顿邮报》就报道了一位法律教授发现 ChatGPT 将他列入了一份对某人进行过性骚扰的法律学者名单。还有报道称ChatGPT 捏造一位澳大利亚市长被判定犯有贿赂罪并被判处监禁!是不是很可怕?随着AIGC的兴起,如果这种AI幻觉不得到有效解决,我们可能被各种捏造的信息裹挟。

AI为什么会产生这种幻觉?

正如小僧上文所述,理解大型语言模型(LLMs)的本质可以帮我们找到答案。大型语言模型的设计,是基于语言的“统计概率”,这意味着AI完全没有“现实世界的经验”,无法有基于事实真假的判断。所以AI不知道什么是正确的,什么是不正确的,只能保持与提示词在统计学上的一致性。

OpenAI的研究人员在报告中写道:“即使是最先进的人工智能模型也很容易产生谎言,它们在不确定的时刻往往表现出捏造事实的倾向。而这些幻觉在需要多步骤推理的领域尤其严重,因为一个逻辑错误就足以破坏一个更大的解决方案。”

不过,从另一个角度来看,这种幻觉恰恰又是AI创造力的表现。因为正是这种创造性回应的能力使AI成为产生新想法或解开思考瓶颈的强大工具,你将其用于脑暴思考、激发灵感时会很有用,但当用作事实参考时就需要谨慎了。

作为营销人员,在使用这类工具时,还是要保持谨慎乐观的态度。因为我们从事的大量工作是创造性或者说是创意性的,AI幻觉可以带来更多灵感和启发,但是还有很多工作是基于客观事实的,这就需要进行交叉核实或验证,而不是完全听之任之。

由此可见,对于AI工具,在效率层面确实是解放了生产力,但在内容真实性层面,我们在使用时,还是需要有基本的识别能力和判断能力。说到底,工具永远是为人所用,而不是完全替代人,是不是感觉到自己的职业稳了?

以上希望能给你启发。